机器之心原创

编辑:吴昕、冷猫

明略科技的专有 gui 大模型 mano 在行业公认的 mind2web 和 osworld 两大挑战性基准测试中,均取得了创纪录的 sota 成绩。通过在线强化学习和训练数据自动采集两大核心创新,mano 为整个 gui 智能体领域提供了一套可扩展、可持续进化的新范式。

我们正在把越来越多的时间交给屏幕。有人算过,人一生中耗在手机上的时间接近 9 年;如果你的工作离不开电脑,这个数字只会更高。时间碎片化,注意力也被点击、勾选、复制粘贴这些琐碎操作蚕食。

如果,这些操作都能交给 agent 呢?点开网页、登录账号、抓取数据、填写表单、提交流程,全程无人值守,你还有理由再手动点鼠标吗?

这背后的市场热度,早已扑面而来。无论是刚落幕的 2025 外滩大会,还是财新亚洲愿景论坛,agent 都是全场最高频的热词,不少观点认为:

真正有用的 agent,必须学会使用手机和电脑,像人一样读懂并操作 gui。

毕竟,你不能靠一句简短的指令就把所有消费记录从大厂数据库里提取出来。

也不能仅凭单一指令完成登录支付宝、微信、淘宝下载账单,并调用 excel 进行数据清理,完成对过去一年消费习惯分析的操作。

一个只能给出口头建议,却不能替你登录、获取数据的助理,价值注定「骨折」。

在这场 gui agent 竞赛中,中美巨头纷纷下场,但成功率低下成了绕不过去的硬伤:眼花缭乱的界面、多变的交互逻辑,让浏览器自动化操作,远比生成一段流畅文字要难得多。

所以,当明略科技带着拥有双榜 sota(当前最先进)成绩的 mano 出场时,就显得格外吸睛。这一成绩不仅让 mano 成为通用 gui 智能体的新范式,也意味着自动化边界又被推远了一大步。

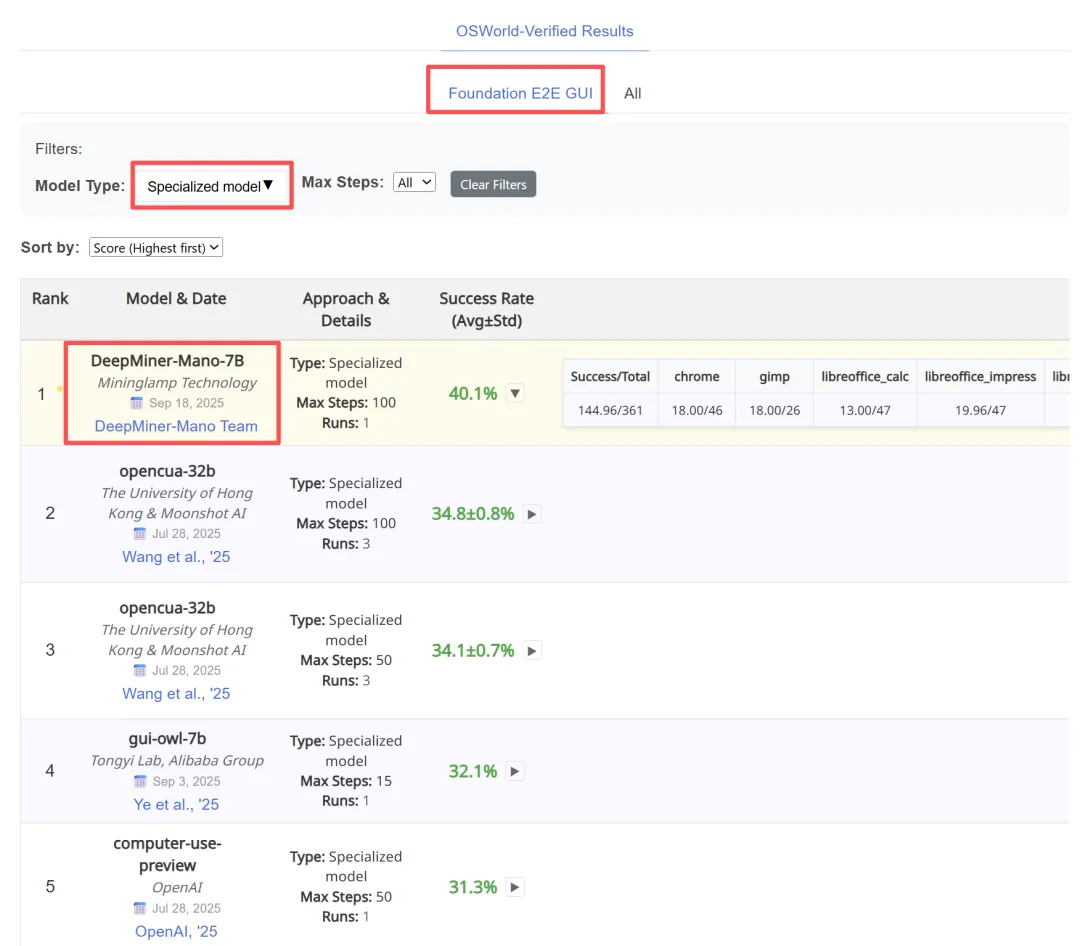

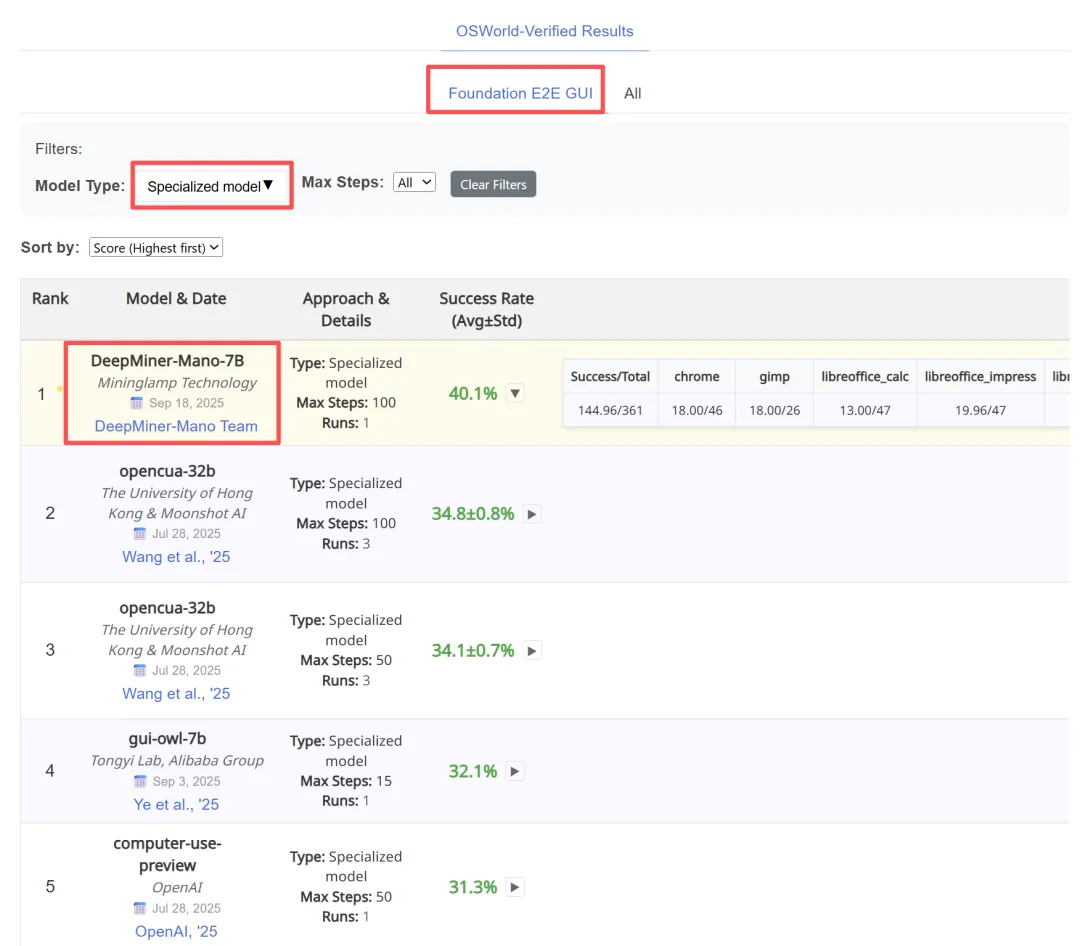

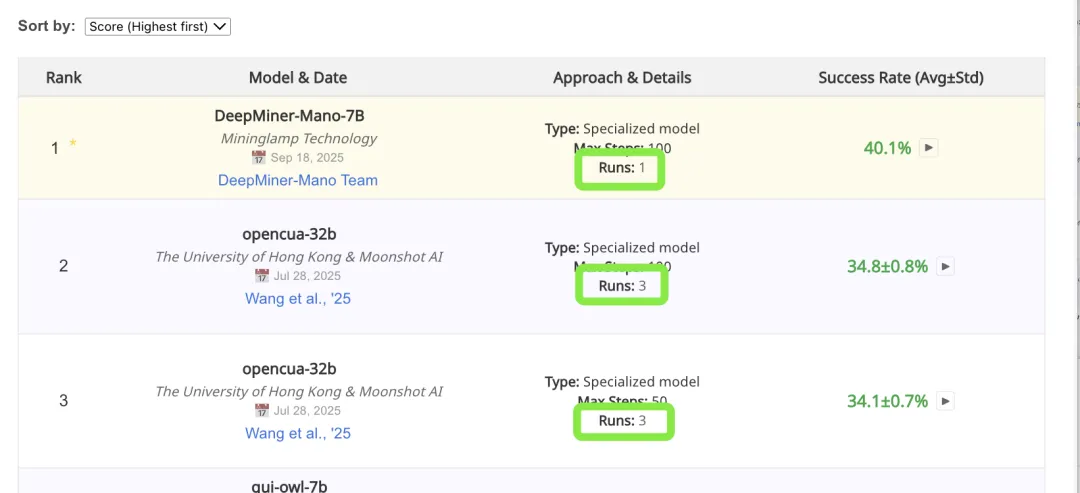

osworld-verified 榜单的 foundation e2e gui & specialized model 评测中取得 sota。

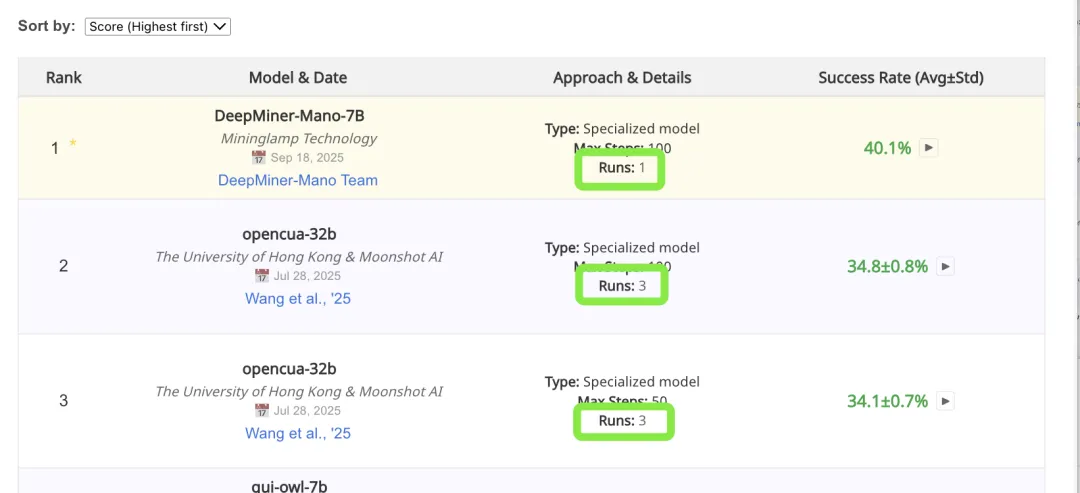

值得一提的是,mano 仅在一次运行中就取得了 osworld-verified 榜单的 foundation e2e gui & specialized model 评测中 40.1% 的成功率,非常令人惊喜。

榜单链接:https://os-world.github.io/

技术报告链接:https://www.mininglamp.com/news/6394/

近日,明略科技推出的基于多模态基础模型的网页 gui 智能体 mano,凭借其强大的性能,在行业内公认的两大挑战基准 ——mind2web 和 osworld 上同时刷新纪录,取得当前最佳成绩(sota)。

首先,在网页端的 mind2web 上,mano 展示出「看得准、做得成」的核心优势。

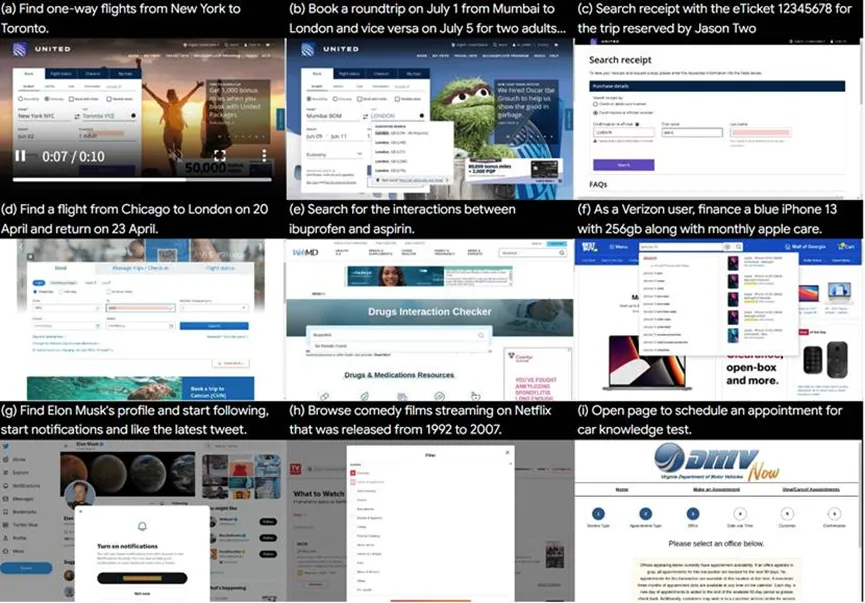

mind2web 覆盖 137 个网站、2350 真实任务,从填写表格到订机票、再到在线购物,应有尽有,旨在考察智能体能否在复杂多变的 dom 结构里精准找到目标元素,并完成整个操作链。

mind2web 覆盖 137 个网站、2350 真实任务,从填写表格到订机票、再到在线购物,应有尽有

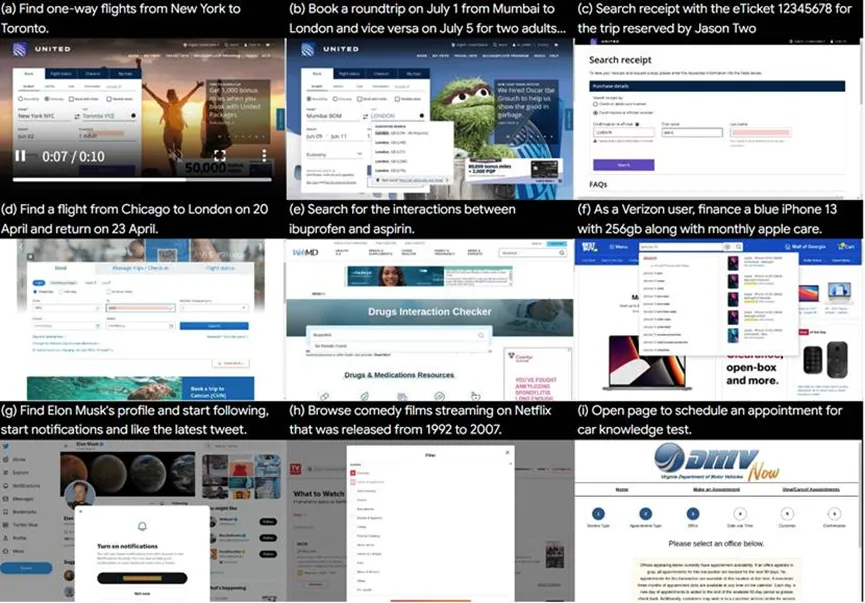

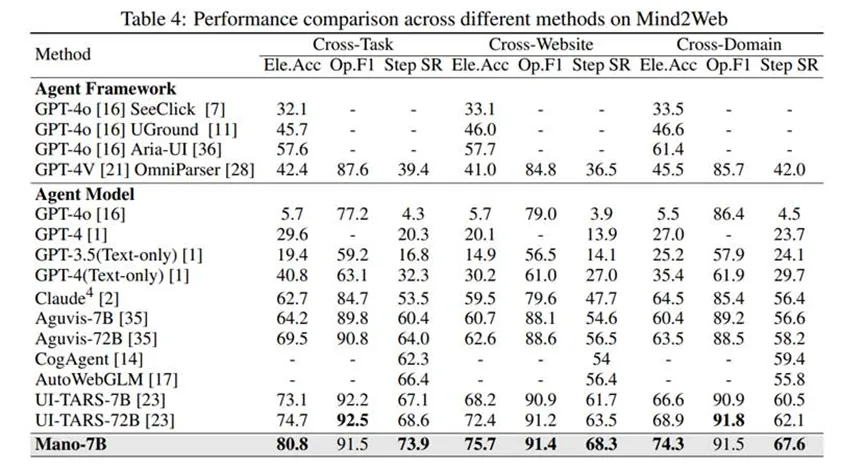

技术报告显示,mano 在三个关键指标上,均表现不俗。

在元素精度 (ele.acc)和步骤成功率(step sr)上遥遥领先 —— 两项指标显著超越了所有 sota 的方法。这表明它在准确识别和定位界面元素,以及成功执行多步任务的能力上达到了新高度。

mano 在操作 f1 (op.f1) 指标上与此前顶尖模型持平甚至略高,这表明它的核心优势并非仅仅来自对操作类型的判断能力,而是能够真正将复杂任务转化为成功的操作序列。

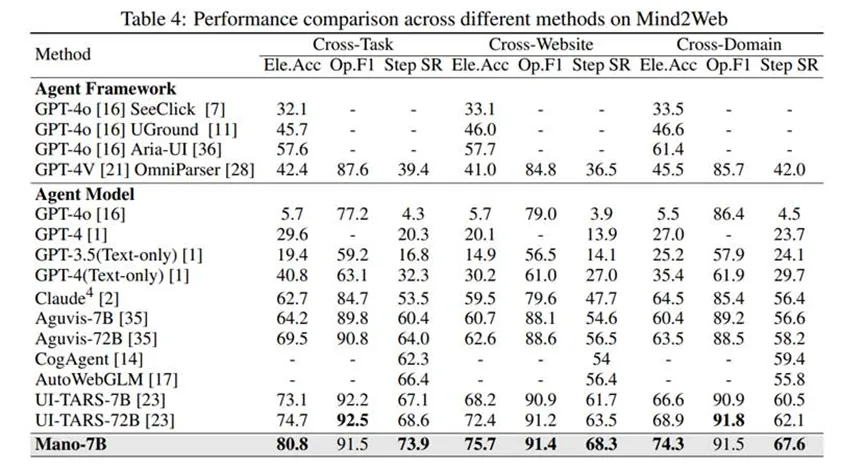

更难的挑战来自桌面端。osworld-verified 涵盖了 369 个跨应用任务,覆盖 10 类应用,包含浏览器,办公软件等多个类型,每一个操作都和真实桌面场景无缝对接,被认为是桌面智能体测评界的「珠峰」。

osworld-verified 作为一个基准测试集,旨在评估模型能否在真实部署场景下完成从头到尾的、复杂的任务链条。

技术报告显示,在 osworld-verified 榜单的 foundation e2e gui & specialized model 评测中,mano 直接把成功率拉到 41.6±0.7%,超过同表所列的 qwen、gui-owl、opencua 等模型。

在 max steps=100 的配置下(mano runs=2),其均值达到 41.6,标准差仅 ±0.7;而 ui-tars-7b 为 27.4±2.2,opencua-32b 在 3 次 runs 下为 34.8±0.8。

mano 在均值上提升约 7 个百分点,整体任务通过率有显著提升。

mano 在 gui 交互领域首次提出了在线强化学习的训练范式,并推出训练数据自动采集的「探索器」,这两大核心创新为其实现前所未有的图形界面交互性能,奠定了坚实基础。

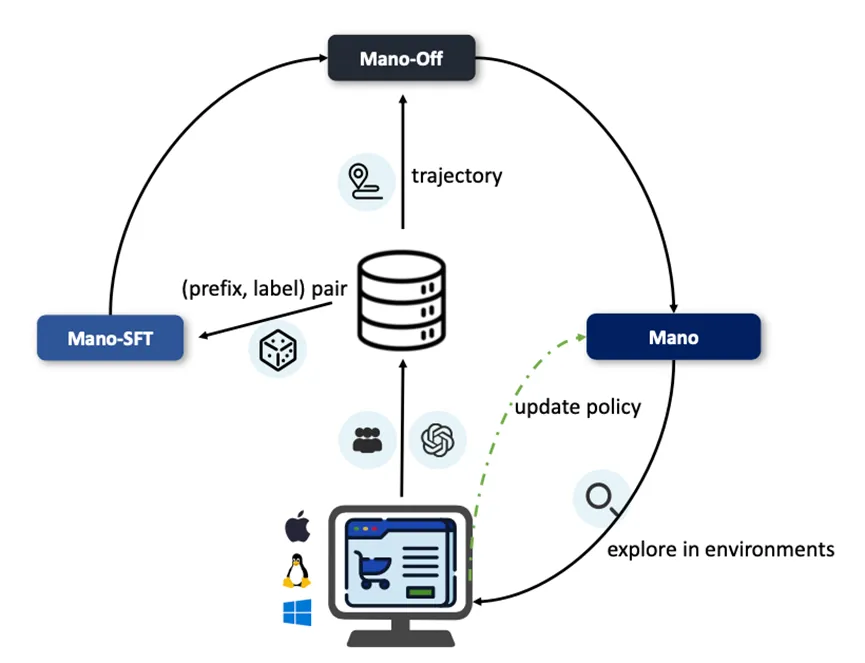

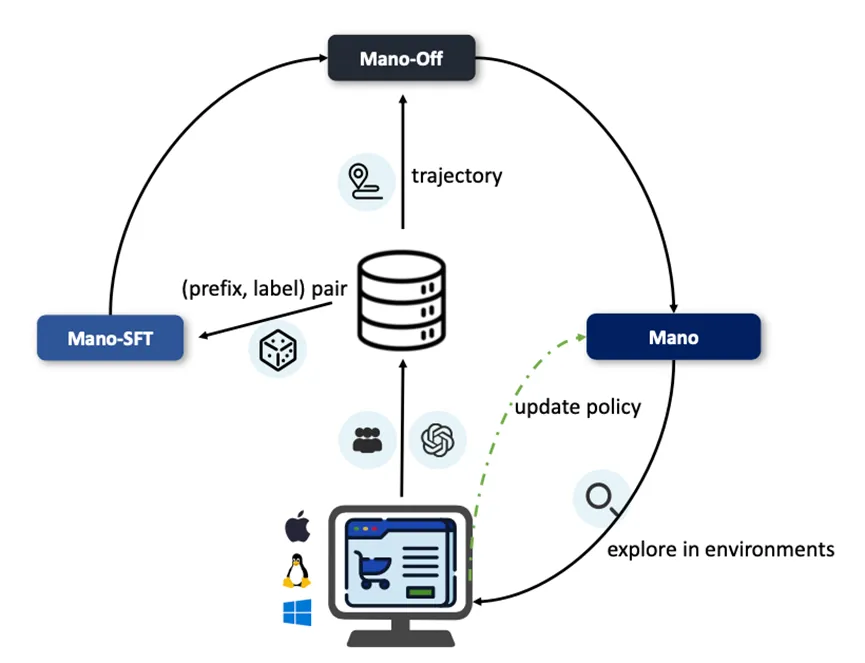

mano 整体框架分为三大部分,探索模块、处理流程以及优化流程。探索模块关注如何获取训练数据,处理流程揭示了 mano 操作网页或电脑的过程。右侧优化流程是「训练时的优化策略」,通过 sft、离线强化学习和在线强化学习的三步走,增强模型在动态 gui 环境中的推理能力、适应性,以及端到端的决策能力。

我们先来唠唠 mano 制霸的决胜因素之一 —— 领域首创的在线强化学习。

自 deepseek 横空出世以来,grpo 已经成为了强化学习黄金范式。这不仅限于大语言模型的范围内,在多种任务领域的智能体模型的训练中都已经有了广泛的应用。

现有的模型训练大多局限在离线强化学习的范畴,在这种模式下,模型深度依赖于事先收集好的数据集进行训练。通过离线强化学习,我们能够充分利用大量历史数据来训练智能体,从而提高模型的推理决策能力,这也是 deepseek 验证成功的技术模式。

回到 mano 的技术框架,其优化流程是一个渐进式的分布策略:

第一阶段,监督微调(sft),使用来自真实数据和跨多个网站与操作系统的模拟环境的精细处理交互数据,对模型进行全参数的 sft,得到初始模型 mano-sft。

第二阶段,与 deepseek 等大模型采用的训练模式类似,mano 采用离线强化学习,结合 grpo 方法进行微调,得到中间模型 mano-off。

以上两个阶段已经能够实现一个具有强大推理决策能力,具备高效交互能力的高质量模型了。

但在 gui 交互智能体领域,任务特性决定了模型任何形式的操作都需要与真实的系统交互环境紧密结合,最终都要应用在实际操作系统的真实环境里。

技术团队在实际验证过程中认为,仅通过以上两个阶段的训练,仍然不足以达到具备足够灵活性和适应性的要求。

为此,他们分享道,mano 模型需要「真正的接入操作系统的真实环境里,需要通过不停地与环境交互,在交互过程中采样到更丰富的真实轨迹来弥补离线训练样本的单一性和稀疏性」。

因此,在两阶段训练的模型基础上,他们在 gui 领域里开创性的提出了在线强化学习的策略,构建了 gui 领域强化学习的新范式。

简单来说,在线强化学习是强化学习的一种形式。智能体根据当前的状态选择一个行动,然后从环境中获得相应的奖励以及新的状态。这些反馈会被用来更新智能体的策略。

在线学习的一个显著特点是:智能体需要在每个时刻都依赖最新数据进行学习,同时不断在探索(尝试新的行动以获取信息)和利用(基于已有知识采取最优行动)之间寻找平衡。

大家是否还记得当年 openai 开发的用来玩 dota 2 的 ai 系统 openai five ?

这个系统的训练模式就是在真实游戏环境中采取自我对战的模式进行在线学习,智能体不断与自己或多个实例对战,产生新的游戏数据。每场对战都会生成大量的经验,最终战胜职业游戏选手。

这种训练逻辑与 gui 交互智能体的训练逻辑有异曲同工之妙,mano 也需要在真实的交互环境中进行不断强化以提高适应性和灵活性。

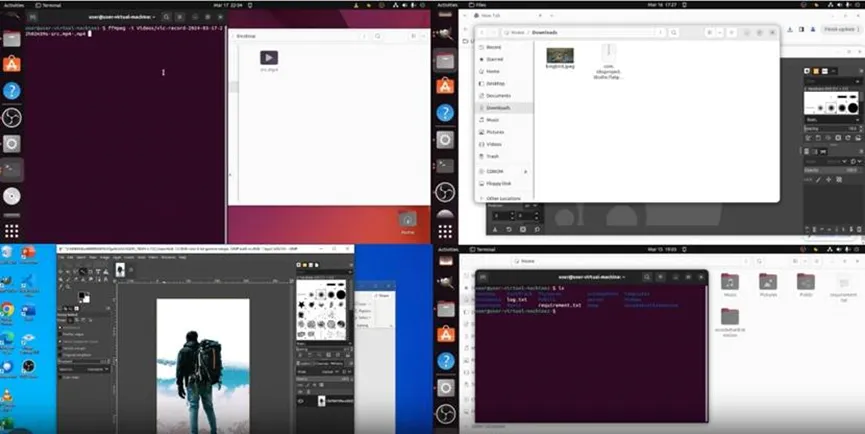

为此,技术团队建立了一个模拟环境池,让模型能够与真实环境交互,包括浏览器环境(bua)和桌面环境(cua)。通过模拟环境,模型能够在「真实交互」中采集更多样化的环境数据,弥补离线轨迹分布稀疏的问题。

技术团队自建模拟环境中部署的在线强化学习,同样基于 grpo,但使用了更注重实时适应性和动态探索的奖励机制。

在此过程中,智能体通过在线试验收集新的交互数据,这些数据会被循环回流到离线训练阶段进行进一步优化,实现持续改进和迭代更新。

最终得到的 mano 模型在多样化的 web gui 场景中展现出更强的鲁棒性。

众所周知,在线强化学习存在交互时间成本过高和缺乏灵活采样的缺陷。为了降低成本,明略科技的技术团队并没有采用在线交互 即时更新的方式,而是采用在线采样 离线过滤的方式:

先收集轨迹,再过滤噪声数据,可以动态调节任务难度分布,避免过多失败轨迹导致的学习效率低下问题。

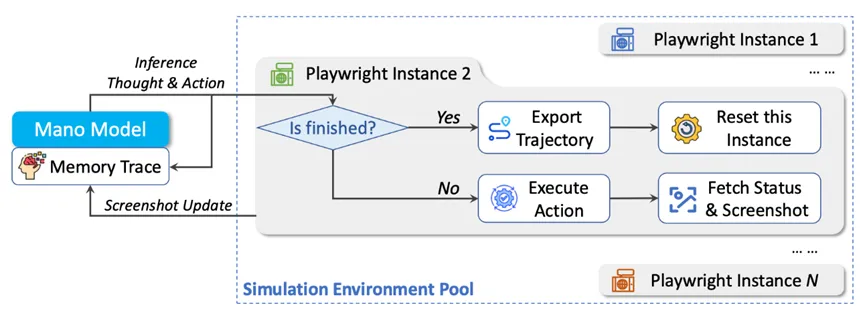

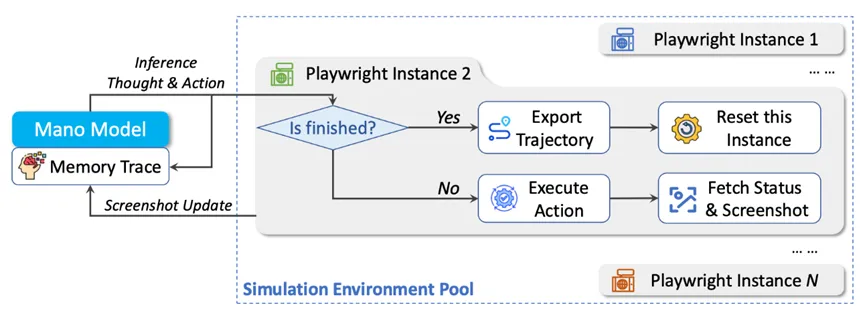

mano 中在线强化学习的整体框架

在完整的在线强化学习流程中,mano 模型与多个并行的 playwright 实例交互,每个实例对应一个独立的 gui 环境。

每一步中,模型会获取环境状态与截图,进行推理生成「思考」与「行动」,并在对应环境中执行该动作。该循环会持续,直到任务完成。

同时,系统会记录记忆轨迹,并将完整的交互轨迹导出,用于后续的训练与分析。

消融实验结果显示,增加了在线强化学习的步骤后,模型在 osworld-verified 数据集上的平均分数产生了一个显著的飞跃,相比离线强化学习的模型结果提升了 7.9,达到 41.6。

在 osworld-verified 上,不同训练阶段的性能对比。

同时,由 sft 到离线强化学习,再到在线强化学习的三个阶段可以迭代循环,直到在验证集上的性能提升趋于饱和。于是得到 mano 最终模型。

要实现高质量的在线强化学习训练,不仅要求模型具备在真实环境中进行探索和交互的能力,还需要海量的交互轨迹数据作为支撑。mano 第二大创新正是聚焦于模型数据获取和轨迹采集。

大模型虽然能理解笼统的指令,但在需要复杂、多步骤操作的目标驱动型任务中,它往往无法独立地将大目标分解为具体的执行步骤:

你说:「帮我买一瓶矿泉水。」他反而会问:「我需要先打开哪个网站?然后要搜索什么?点击哪个按钮?」

这时,开发者必须像教小孩一样,手把手地告诉模型每一步该怎么做,极大地增加了开发工作量。

因此,研发人员迫切需要为交互任务构建专用的模型和智能体。而在这一过程中,海量的高质量交互轨迹数据是不可或缺的。过去,这类数据往往需要通过人工构建或标注,成本高、耗时长。明略的技术团队则设计了训练数据自动采集的方法,从根本上提升了数据收集的效率和准确性。

首先,技术团队搭建了一个可扩展的虚拟环境集群,用于模拟多种交互场景。针对每个目标应用,无论是网页 url 还是桌面软件模块,团队通过大语言模型自动生成目标清单,并对目标进行优先级排序,过滤掉使用频率极低的功能,为后续探索提供明确的上下文指导。

在元素提取方面,团队为网页环境定制了 chrome 插件「mano-c」,该插件能够全面提取网页中的交互元素,捕捉其空间坐标与语义属性。

通过系统化的 dom 树遍历,识别出网页中的可交互元素,并设计了多层级过滤机制,排除视窗外的元素,检查 css 属性,剔除不可见元素,并过滤掉极小尺寸的隐形追踪元素。

对于桌面环境,则采用 a11y tree 解析与 omniparsev2 协同过滤的方法,确保覆盖更多交互元素,尤其是那些单一方法可能遗漏的元素。

在数据标注方面,技术团队利用大语言模型为每个提取的元素生成语义标签、功能描述及交互类别,形成结构化的语义对齐数据,为后续的训练提供了有效的监督信号。

为了让数据采集更具智能性,他们设计了基于 prompt 的探索模块,用于智能选择交互元素,并引入显式约束,避免路径循环和冗余分支。

探索过程中,采用深度优先搜索(dfs)策略,最大深度设为 10 层,从而在探索覆盖率和计算效率之间找到平衡。

每个探索状态下,系统会截取截图并保存带注释的交互数据。

完成探索后,团队又设计了一套轨迹评估机制,以筛选出高质量的交互序列。

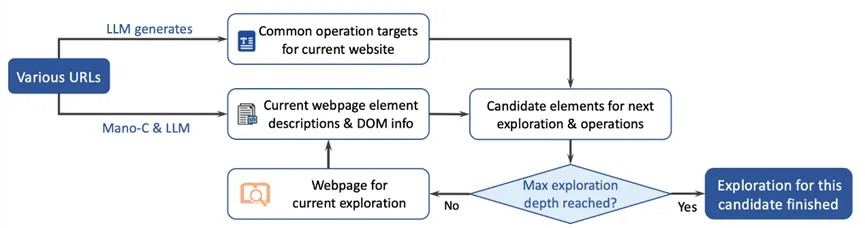

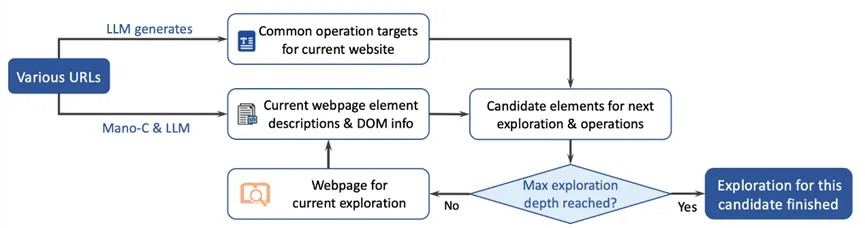

自动化引擎架构示意图。

简而言之,这个自动化的工作流程如同一次网页探索。

系统首先会打开不同的网址,识别可点击或输入的元素,并通过插件抓取网页中的交互元素,同时收集该元素的描述及 dom 信息,并利用大语言模型生成语义对齐数据。

接下来,系统会从这些候选元素中挑选目标,开始逐步探索。整个过程会不断循环,每一步都会检查是否已达到最大探索深度,若未达到,则继续进行探索。

通过这两个核心创新,团队实现了数据采集的循环更新。

数据循环示意图

随着 2025 年 ai agent 需求的爆发,明略科技依托自研的大模型和独有数据资产,推出商业数据分析智能体 deepminer。

其核心亮点在于能够获取更完整、实时的数据,为数据分析报告和深度研究提供更有力支持。而这一核心优势背后,正是 mano 的技术支撑。

目前市面上大多数 ai agent(如 manus、genspark)获取数据的方式较为传统,通常依赖平台开发 api 或通过 mcp 协议直接抓取数据,因此,数据来源缺乏独特性和壁垒。

真正的竞争壁垒来自于那些既没有开放 api,又没有 mcp 协议的专业网站。一般来说,这些数据只能通过用户手动登录账户,设置条件后才能获取。

例如,在亚马逊后台,用户需要手动选择最近 30 天的数据、输入关键词、根据流量趋势进行排序,才能筛选出所需数据。

为了能够访问这些其他同类 agent 无法触及的数据源,mano 应运而生,成为差异化竞争中的关键角色。

而这一通用 gui 智能体的 sota 表现,源于明略科技多年来在多模态大模型和数据智能领域的积淀。

几年前,明略科技便开始构建知识图谱,将「事件」、「时间」、「空间」等要素融入其中,为多模态信息的深度关联和逻辑推理打下了基础。

接着,通过自然语言处理和机器学习,明略科技将企业数据转化为可操作的商业洞察,涵盖从营销到运营管理等多个应用场景,推动技术与商业的深度融合。

2024 年,明略科技的超图多模态大语言模型(hmllm)和 video-sme 数据集荣获 acm mm 2024 最佳论文提名,并在脑电图、眼动等非标模态数据处理领域取得显著突破。2025 年推出的 pre-map 模型进一步推动了高分辨率个性化视觉预测。这些学术突破也为 mano 在 gui 智能体领域的出色表现,提供了坚实的技术支撑。

作为平台的自动化引擎,mano 通过拟人化交互精准完成各类复杂网页操作。其核心技术突破在于,通过持续强化学习,mano 能够自主适应和探索全新的平台与业务流程。这种高度适应性使其能够高效、智能地执行网页操作与数据采集任务,大幅降低传统自动化方案在应对业务变更时的适配与维护成本。

未来,明略科技将继续在数据采集、训练推理整合、验证码处理等领域探索,推动 mano 在真实应用和端侧部署中的进一步优化,为企业的智能化转型提供强有力的支持。

关于现金娱乐平台游戏

作为明略科技旗下核心营销智能品牌,秒针系统自2006年成立以来,已深耕营销科学领域19年,累计服务超2000家国内外头部企业,深度整合”媒介、内容、用户“全域数据资产,通过营销智能技术提升营销实效。

在agentic marketing时代,秒针系统基于ai,高于ai,以事实性数据反ai幻觉,有效连接ai-品牌-真实消费者。通过ai agent全营销链路融合,做”秒”懂品牌需求的智能营销搭子,洞察真、策略准、行动快,让每一分营销预算都创造真实增长。

机器之心原创

编辑:吴昕、冷猫

明略科技的专有 gui 大模型 mano 在行业公认的 mind2web 和 osworld 两大挑战性基准测试中,均取得了创纪录的 sota 成绩。通过在线强化学习和训练数据自动采集两大核心创新,mano 为整个 gui 智能体领域提供了一套可扩展、可持续进化的新范式。

我们正在把越来越多的时间交给屏幕。有人算过,人一生中耗在手机上的时间接近 9 年;如果你的工作离不开电脑,这个数字只会更高。时间碎片化,注意力也被点击、勾选、复制粘贴这些琐碎操作蚕食。

如果,这些操作都能交给 agent 呢?点开网页、登录账号、抓取数据、填写表单、提交流程,全程无人值守,你还有理由再手动点鼠标吗?

这背后的市场热度,早已扑面而来。无论是刚落幕的 2025 外滩大会,还是财新亚洲愿景论坛,agent 都是全场最高频的热词,不少观点认为:

真正有用的 agent,必须学会使用手机和电脑,像人一样读懂并操作 gui。

毕竟,你不能靠一句简短的指令就把所有消费记录从大厂数据库里提取出来。

也不能仅凭单一指令完成登录支付宝、微信、淘宝下载账单,并调用 excel 进行数据清理,完成对过去一年消费习惯分析的操作。

一个只能给出口头建议,却不能替你登录、获取数据的助理,价值注定「骨折」。

在这场 gui agent 竞赛中,中美巨头纷纷下场,但成功率低下成了绕不过去的硬伤:眼花缭乱的界面、多变的交互逻辑,让浏览器自动化操作,远比生成一段流畅文字要难得多。

所以,当明略科技带着拥有双榜 sota(当前最先进)成绩的 mano 出场时,就显得格外吸睛。这一成绩不仅让 mano 成为通用 gui 智能体的新范式,也意味着自动化边界又被推远了一大步。

osworld-verified 榜单的 foundation e2e gui & specialized model 评测中取得 sota。

值得一提的是,mano 仅在一次运行中就取得了 osworld-verified 榜单的 foundation e2e gui & specialized model 评测中 40.1% 的成功率,非常令人惊喜。

榜单链接:https://os-world.github.io/

技术报告链接:https://www.mininglamp.com/news/6394/

近日,明略科技推出的基于多模态基础模型的网页 gui 智能体 mano,凭借其强大的性能,在行业内公认的两大挑战基准 ——mind2web 和 osworld 上同时刷新纪录,取得当前最佳成绩(sota)。

首先,在网页端的 mind2web 上,mano 展示出「看得准、做得成」的核心优势。

mind2web 覆盖 137 个网站、2350 真实任务,从填写表格到订机票、再到在线购物,应有尽有,旨在考察智能体能否在复杂多变的 dom 结构里精准找到目标元素,并完成整个操作链。

mind2web 覆盖 137 个网站、2350 真实任务,从填写表格到订机票、再到在线购物,应有尽有

技术报告显示,mano 在三个关键指标上,均表现不俗。

在元素精度 (ele.acc)和步骤成功率(step sr)上遥遥领先 —— 两项指标显著超越了所有 sota 的方法。这表明它在准确识别和定位界面元素,以及成功执行多步任务的能力上达到了新高度。

mano 在操作 f1 (op.f1) 指标上与此前顶尖模型持平甚至略高,这表明它的核心优势并非仅仅来自对操作类型的判断能力,而是能够真正将复杂任务转化为成功的操作序列。

更难的挑战来自桌面端。osworld-verified 涵盖了 369 个跨应用任务,覆盖 10 类应用,包含浏览器,办公软件等多个类型,每一个操作都和真实桌面场景无缝对接,被认为是桌面智能体测评界的「珠峰」。

osworld-verified 作为一个基准测试集,旨在评估模型能否在真实部署场景下完成从头到尾的、复杂的任务链条。

技术报告显示,在 osworld-verified 榜单的 foundation e2e gui & specialized model 评测中,mano 直接把成功率拉到 41.6±0.7%,超过同表所列的 qwen、gui-owl、opencua 等模型。

在 max steps=100 的配置下(mano runs=2),其均值达到 41.6,标准差仅 ±0.7;而 ui-tars-7b 为 27.4±2.2,opencua-32b 在 3 次 runs 下为 34.8±0.8。

mano 在均值上提升约 7 个百分点,整体任务通过率有显著提升。

mano 在 gui 交互领域首次提出了在线强化学习的训练范式,并推出训练数据自动采集的「探索器」,这两大核心创新为其实现前所未有的图形界面交互性能,奠定了坚实基础。

mano 整体框架分为三大部分,探索模块、处理流程以及优化流程。探索模块关注如何获取训练数据,处理流程揭示了 mano 操作网页或电脑的过程。右侧优化流程是「训练时的优化策略」,通过 sft、离线强化学习和在线强化学习的三步走,增强模型在动态 gui 环境中的推理能力、适应性,以及端到端的决策能力。

我们先来唠唠 mano 制霸的决胜因素之一 —— 领域首创的在线强化学习。

自 deepseek 横空出世以来,grpo 已经成为了强化学习黄金范式。这不仅限于大语言模型的范围内,在多种任务领域的智能体模型的训练中都已经有了广泛的应用。

现有的模型训练大多局限在离线强化学习的范畴,在这种模式下,模型深度依赖于事先收集好的数据集进行训练。通过离线强化学习,我们能够充分利用大量历史数据来训练智能体,从而提高模型的推理决策能力,这也是 deepseek 验证成功的技术模式。

回到 mano 的技术框架,其优化流程是一个渐进式的分布策略:

第一阶段,监督微调(sft),使用来自真实数据和跨多个网站与操作系统的模拟环境的精细处理交互数据,对模型进行全参数的 sft,得到初始模型 mano-sft。

第二阶段,与 deepseek 等大模型采用的训练模式类似,mano 采用离线强化学习,结合 grpo 方法进行微调,得到中间模型 mano-off。

以上两个阶段已经能够实现一个具有强大推理决策能力,具备高效交互能力的高质量模型了。

但在 gui 交互智能体领域,任务特性决定了模型任何形式的操作都需要与真实的系统交互环境紧密结合,最终都要应用在实际操作系统的真实环境里。

技术团队在实际验证过程中认为,仅通过以上两个阶段的训练,仍然不足以达到具备足够灵活性和适应性的要求。

为此,他们分享道,mano 模型需要「真正的接入操作系统的真实环境里,需要通过不停地与环境交互,在交互过程中采样到更丰富的真实轨迹来弥补离线训练样本的单一性和稀疏性」。

因此,在两阶段训练的模型基础上,他们在 gui 领域里开创性的提出了在线强化学习的策略,构建了 gui 领域强化学习的新范式。

简单来说,在线强化学习是强化学习的一种形式。智能体根据当前的状态选择一个行动,然后从环境中获得相应的奖励以及新的状态。这些反馈会被用来更新智能体的策略。

在线学习的一个显著特点是:智能体需要在每个时刻都依赖最新数据进行学习,同时不断在探索(尝试新的行动以获取信息)和利用(基于已有知识采取最优行动)之间寻找平衡。

大家是否还记得当年 openai 开发的用来玩 dota 2 的 ai 系统 openai five ?

这个系统的训练模式就是在真实游戏环境中采取自我对战的模式进行在线学习,智能体不断与自己或多个实例对战,产生新的游戏数据。每场对战都会生成大量的经验,最终战胜职业游戏选手。

这种训练逻辑与 gui 交互智能体的训练逻辑有异曲同工之妙,mano 也需要在真实的交互环境中进行不断强化以提高适应性和灵活性。

为此,技术团队建立了一个模拟环境池,让模型能够与真实环境交互,包括浏览器环境(bua)和桌面环境(cua)。通过模拟环境,模型能够在「真实交互」中采集更多样化的环境数据,弥补离线轨迹分布稀疏的问题。

技术团队自建模拟环境中部署的在线强化学习,同样基于 grpo,但使用了更注重实时适应性和动态探索的奖励机制。

在此过程中,智能体通过在线试验收集新的交互数据,这些数据会被循环回流到离线训练阶段进行进一步优化,实现持续改进和迭代更新。

最终得到的 mano 模型在多样化的 web gui 场景中展现出更强的鲁棒性。

众所周知,在线强化学习存在交互时间成本过高和缺乏灵活采样的缺陷。为了降低成本,明略科技的技术团队并没有采用在线交互 即时更新的方式,而是采用在线采样 离线过滤的方式:

先收集轨迹,再过滤噪声数据,可以动态调节任务难度分布,避免过多失败轨迹导致的学习效率低下问题。

mano 中在线强化学习的整体框架

在完整的在线强化学习流程中,mano 模型与多个并行的 playwright 实例交互,每个实例对应一个独立的 gui 环境。

每一步中,模型会获取环境状态与截图,进行推理生成「思考」与「行动」,并在对应环境中执行该动作。该循环会持续,直到任务完成。

同时,系统会记录记忆轨迹,并将完整的交互轨迹导出,用于后续的训练与分析。

消融实验结果显示,增加了在线强化学习的步骤后,模型在 osworld-verified 数据集上的平均分数产生了一个显著的飞跃,相比离线强化学习的模型结果提升了 7.9,达到 41.6。

在 osworld-verified 上,不同训练阶段的性能对比。

同时,由 sft 到离线强化学习,再到在线强化学习的三个阶段可以迭代循环,直到在验证集上的性能提升趋于饱和。于是得到 mano 最终模型。

要实现高质量的在线强化学习训练,不仅要求模型具备在真实环境中进行探索和交互的能力,还需要海量的交互轨迹数据作为支撑。mano 第二大创新正是聚焦于模型数据获取和轨迹采集。

大模型虽然能理解笼统的指令,但在需要复杂、多步骤操作的目标驱动型任务中,它往往无法独立地将大目标分解为具体的执行步骤:

你说:「帮我买一瓶矿泉水。」他反而会问:「我需要先打开哪个网站?然后要搜索什么?点击哪个按钮?」

这时,开发者必须像教小孩一样,手把手地告诉模型每一步该怎么做,极大地增加了开发工作量。

因此,研发人员迫切需要为交互任务构建专用的模型和智能体。而在这一过程中,海量的高质量交互轨迹数据是不可或缺的。过去,这类数据往往需要通过人工构建或标注,成本高、耗时长。明略的技术团队则设计了训练数据自动采集的方法,从根本上提升了数据收集的效率和准确性。

首先,技术团队搭建了一个可扩展的虚拟环境集群,用于模拟多种交互场景。针对每个目标应用,无论是网页 url 还是桌面软件模块,团队通过大语言模型自动生成目标清单,并对目标进行优先级排序,过滤掉使用频率极低的功能,为后续探索提供明确的上下文指导。

在元素提取方面,团队为网页环境定制了 chrome 插件「mano-c」,该插件能够全面提取网页中的交互元素,捕捉其空间坐标与语义属性。

通过系统化的 dom 树遍历,识别出网页中的可交互元素,并设计了多层级过滤机制,排除视窗外的元素,检查 css 属性,剔除不可见元素,并过滤掉极小尺寸的隐形追踪元素。

对于桌面环境,则采用 a11y tree 解析与 omniparsev2 协同过滤的方法,确保覆盖更多交互元素,尤其是那些单一方法可能遗漏的元素。

在数据标注方面,技术团队利用大语言模型为每个提取的元素生成语义标签、功能描述及交互类别,形成结构化的语义对齐数据,为后续的训练提供了有效的监督信号。

为了让数据采集更具智能性,他们设计了基于 prompt 的探索模块,用于智能选择交互元素,并引入显式约束,避免路径循环和冗余分支。

探索过程中,采用深度优先搜索(dfs)策略,最大深度设为 10 层,从而在探索覆盖率和计算效率之间找到平衡。

每个探索状态下,系统会截取截图并保存带注释的交互数据。

完成探索后,团队又设计了一套轨迹评估机制,以筛选出高质量的交互序列。

自动化引擎架构示意图。

简而言之,这个自动化的工作流程如同一次网页探索。

系统首先会打开不同的网址,识别可点击或输入的元素,并通过插件抓取网页中的交互元素,同时收集该元素的描述及 dom 信息,并利用大语言模型生成语义对齐数据。

接下来,系统会从这些候选元素中挑选目标,开始逐步探索。整个过程会不断循环,每一步都会检查是否已达到最大探索深度,若未达到,则继续进行探索。

通过这两个核心创新,团队实现了数据采集的循环更新。

数据循环示意图

随着 2025 年 ai agent 需求的爆发,明略科技依托自研的大模型和独有数据资产,推出商业数据分析智能体 deepminer。

其核心亮点在于能够获取更完整、实时的数据,为数据分析报告和深度研究提供更有力支持。而这一核心优势背后,正是 mano 的技术支撑。

目前市面上大多数 ai agent(如 manus、genspark)获取数据的方式较为传统,通常依赖平台开发 api 或通过 mcp 协议直接抓取数据,因此,数据来源缺乏独特性和壁垒。

真正的竞争壁垒来自于那些既没有开放 api,又没有 mcp 协议的专业网站。一般来说,这些数据只能通过用户手动登录账户,设置条件后才能获取。

例如,在亚马逊后台,用户需要手动选择最近 30 天的数据、输入关键词、根据流量趋势进行排序,才能筛选出所需数据。

为了能够访问这些其他同类 agent 无法触及的数据源,mano 应运而生,成为差异化竞争中的关键角色。

而这一通用 gui 智能体的 sota 表现,源于明略科技多年来在多模态大模型和数据智能领域的积淀。

几年前,明略科技便开始构建知识图谱,将「事件」、「时间」、「空间」等要素融入其中,为多模态信息的深度关联和逻辑推理打下了基础。

接着,通过自然语言处理和机器学习,明略科技将企业数据转化为可操作的商业洞察,涵盖从营销到运营管理等多个应用场景,推动技术与商业的深度融合。

2024 年,明略科技的超图多模态大语言模型(hmllm)和 video-sme 数据集荣获 acm mm 2024 最佳论文提名,并在脑电图、眼动等非标模态数据处理领域取得显著突破。2025 年推出的 pre-map 模型进一步推动了高分辨率个性化视觉预测。这些学术突破也为 mano 在 gui 智能体领域的出色表现,提供了坚实的技术支撑。

作为平台的自动化引擎,mano 通过拟人化交互精准完成各类复杂网页操作。其核心技术突破在于,通过持续强化学习,mano 能够自主适应和探索全新的平台与业务流程。这种高度适应性使其能够高效、智能地执行网页操作与数据采集任务,大幅降低传统自动化方案在应对业务变更时的适配与维护成本。

未来,明略科技将继续在数据采集、训练推理整合、验证码处理等领域探索,推动 mano 在真实应用和端侧部署中的进一步优化,为企业的智能化转型提供强有力的支持。

关于现金娱乐平台游戏

作为明略科技旗下核心营销智能品牌,秒针系统自2006年成立以来,已深耕营销科学领域19年,累计服务超2000家国内外头部企业,深度整合”媒介、内容、用户“全域数据资产,通过营销智能技术提升营销实效。

在agentic marketing时代,秒针系统基于ai,高于ai,以事实性数据反ai幻觉,有效连接ai-品牌-真实消费者。通过ai agent全营销链路融合,做”秒”懂品牌需求的智能营销搭子,洞察真、策略准、行动快,让每一分营销预算都创造真实增长。